L’inchiesta di una delle principali riviste scientifiche del pianeta, Science, ha seminato lo scompiglio nel mondo della ricerca. John Bohannon, questo il nome dell’autore dell’articolo, la bomba l’ha lanciata dalle colonne della rivista americana con un pezzo dal titolo Chi ha paura della peer review? Ora, la peer review (letteralmente, la «revisione dei pari») è la colonna portante del paradigma della «buona scienza». E quel processo per cui, quando un gruppo di scienziati manda un lavoro di ricerca a una rivista per la sua pubblicazione, la rivista si occupa di trovare due o tre esperti del tema che hanno il compito di fare le pulci al testo. Se il processo finisce bene, la ricerca si considera validata e, dunque, pubblicabile; in caso contrario, l’articolo viene respinto e non dato alle stampe. Gli esperti normalmente (anche se non sempre e non in tutte le discipline) sono anonimi e vengono scelti dall’editore della rivista, volta per volta, a seconda dell’argomento. Il tasso di accettazione di un articolo è piuttosto basso.

Ad esempio, la rivista Nature Genetics, del gruppo della più famosa Nature, nel 2011 ha respinto l’83% degli articoli che le sono stati inviati. Fin qui tutto bene: in linea di massima il processo è selettivo e dovrebbe fornire un filtro per garantire che, a essere pubblicata, sia solo la buona scienza. La realtà, però, è molto più complessa. Esiste obiettivamente una tendenza a pubblicare le ricerche più mediatiche e popolari, soprattutto da parte delle riviste scientifiche meno settoriali e più generaliste, come Nature e Science, che sono anche quelle su cui un articolo conta di più. I «pari», poi, non sempre sono all’altezza del compito – che svolgono gratuitamente e in aggiunta al loro lavoro quotidiano – e, soprattutto, non sono sempre capaci di smascherare le truffe, i cui casi, ultimamente, stanno aumentando. Invenzioni creative Secondo uno studio di Nature, negli ultimi dieci anni, la quantità di articoli che sono stati ritirati dalle riviste scientifiche è aumentata di ben 120 volte. Un esempio famoso è il caso di Hwang Woo-suk, il ricercatore sudcoreano che fino al 2006 veniva considerato il maggior esperto mondiale di donazione (nel 2004 annunciò di aver donato per la prima volta un essere umano) e che fu costretto a dimettersi per frode (Science ritirò due suoi articoli).

Un altro caso, stavolta in fisica, fu quello di Jan Henrik Schòn, un esperto di superconduttori diventato una stella del suo campo per la prolificità e l’originalità dei suoi articoli scientifici. Peccato che i dati fossero tutti inventati, come emerse nel 2002. Più di venticinque suoi articoli vennero ritirati dalle principali riviste scientifiche mondiali. Vale la pena menzionare anche il caso della famosa truffa sulla correlazione fra i vaccini e l’autismo, pubblicata nel 1998 su Lancet a firma del medico Andrew Wakefield: i dati erano falsi e la ricerca farlocca. Anche lì, Lancet con molte scuse, dovette ritirare l’articolo. Per non parlare del campo della psicologia, gravemente colpito dalla frode dell’olandese Diederik Stapel che pubblicò più di trenta articoli in riviste peer-reviewed (tra cui Science), inventandosi di sana pianta i dati (che però «dimostravano» fenomeni mediaticamente interessanti). La polemica che ha acceso il mondo scientifico, però, ha come protagonista un gruppo molto speciale di riviste scientifiche: quelle open access.

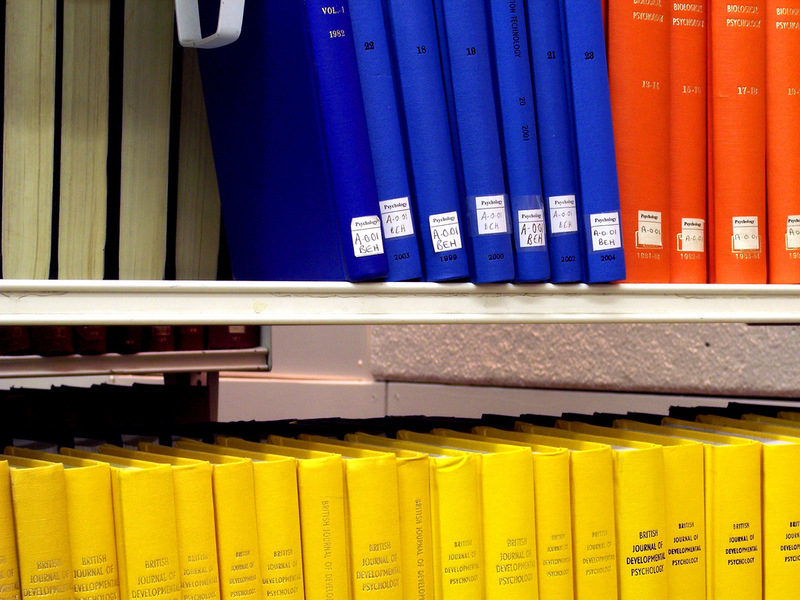

Le riviste menzionate sinora funzionano tutte più o meno così: se supera la peer review, il ricercatore pubblica gratis (o a un prezzo ridotto, secondo i casi). Chi pagherà la rivista – che è una impresa e pertanto si regge sul profitto – saranno i suoi lettori. Ossia, le biblioteche universitarie di mezzo mondo. L’altra metà, quella povera, non può permettersi i prezzi stratosferici degli abbonamenti. Di qui, l’idea di fondare riviste ad accesso libero, i cui costi sono sostenuti da chi pubblica e non da chi compra. La principale rivista che ha fatto questa scelta si chiama Plos One, una ammiraglia che con i suoi ventitremila articoli pubblicati nel 2012 è diventata un punto di riferimento. Oltretutto, siccome Plos One non si stampa su carta, ha dei costi contenuti anche per gli autori. Le principali riviste sul mercato hanno visto fin dall’inizio come fumo negli occhi l’open access.

Anche se quasi tutte le riviste, ormai, hanno dovuto adattare le loro politiche sul copyright dopo un certo numero di mesi, molte rendono pubblici i loro articoli. Oggi persino i programmi finanziati dall’Unione Europea richiedono che gli articoli scientifici siano depositati, almeno da un certo momento in poi, in database a libero accesso. Il Nobel per la fisica, Randy W. Schekman, è un fan dell’open access ed è il direttore di eLife, nata nel 2012. Tornando al polemico articolo di John Bohannon, la questione è che riviste open access, negli ultimi anni, sono nate come funghi. E il sospetto è che non tutte siano serie. Così il giornalista ha condotto un’indagine, «la prima di questo genere», come ha sottolineato Daniele Fanelli, biologo e sociologo della scienza dell’Institute for the study of science technology and innovation di Edinburgo. Ha costruito una serie di articoli scientifici implausibili agli occhi di qualsiasi esperto, tutti con la stessa struttura ma con alcuni dettagli modificati e, utilizzando nomi di ricercatori inesistenti, ne ha sottoposto una versione a tappeto a trecentoquattro riviste open access di settori disciplinari affini al tema della sua presunta ricerca.

Un sistema da rivedere

Il risultato, raccontato da Bohannon, è stato sconcertante. Più del 50% delle riviste (centocinquantotto) che si dichiaravano tutte peer-reviewed accettò il paper senza colpo ferire (a rifiutarlo sono state solo novantotto). Con alcune notevoli eccezioni, fra cui appunto Plos One (eLife ha specificato Bohannon al manifesto, non era stata presa in considerazione). Da qui, la furiosa polemica. «Sono d’accordo con chi dice che, per completezza, avrebbe dovuto studiare un gruppo di controllo, e cioè mandare lo stesso articolo anche a riviste non open access, e vedere cosa sarebbe accaduto – ha spiegato Fanelli – Tuttavia, il dato è preoccupante. E i casi sono due: o l’open access (che comunque rappresenta il futuro) non funziona, oppure è proprio tutto il sistema della peer review che andrebbe rivisto. Spesso dimentichiamo che la conoscenza scientifica è affidabile non perché gli scienziati siano più intelligenti degli altri, ma perché le loro ricerche possono essere replicate o criticate». Lo stesso Bohannon è rimasto sorpreso: «Non mi aspettavo questi numeri. Pensavo al massimo al 10 o 20%», ha affermato.

Tra i molti critici, c’è il linguista Curt Rice, aperto difensore dell’open access e columnist del Guardian. Rice ha attaccato Science, dicendo che ha tratto le conclusioni sbagliate: «Il vero problema della scienza è il controllo della qualità – nelle riviste tradizionali e in quelle open accesso, ha scritto. Abbiamo bisogno di un nuovo approccio (…) come per esempio il progetto valutazione aperta, una valutazione completamente trasparente e online (su riviste come Plos). Una proposta complementare a quella di Fanelli: «Il discrimine iniziale dovrebbe essere una valutazione severa sul metodo e sui criteri su cui è costruita una determinata ricerca: una volta verificati questi parametri, si dovrebbe pubblicare tutto, indipendentemente dai risultati. Saranno gli altri scienziati che nel tempo ne valuteranno la bontà». L’«Impact factor. Anche Ilorenc Arguimbau, bibliometrista e coordinatore dell’Osservatorio della ricerca dell’Istituto di studi catalani di Barcellona si è mostrato d’accordo: «Il problema sono le cattive pratiche di alcune case editrici, non l’open access in sé. Sono a favore della massima trasparenza nella peer review».

Sorprendentemente, né Bohannon, né altri hanno preso in considerazione un altro parametro a cui il mondo scientifico dà molta importanza: l’ impact factor, un numero che calcola il «peso» di una rivista. Riviste come Nature o Science hanno impatti superiori a trenta; Plos, con il suo enorme volume di articoli, viaggia intorno a quattro. Bohannon ha ammesso poi di non aver correlato l’accettazione o il respingimento del suo articolo civetta con l’eventuale presenza di impact factor. «Ma l’ impact factor – ha aggiunto Arguimbau – è un indicatore problematico per gli studi bibliometrici perché non è direttamente correlato con la bontà di una ricerca È solo una media aritmetica, una speranza statistica». Sia come sia, misurare la qualità rimane un problema. A patto che si faccia pulizia di chi se ne approfitta, l’open access può aprire nuove strade per la condivisione del sapere. Ma la formula per capire come garantire che emergano solo le ricerche migliori non è e non sarà semplice da scrivere.

L’Associazione Luca Coscioni è una associazione no profit di promozione sociale. Tra le sue priorità vi sono l’affermazione delle libertà civili e i diritti umani, in particolare quello alla scienza, l’assistenza personale autogestita, l’abbattimento della barriere architettoniche, le scelte di fine vita, la legalizzazione dell’eutanasia, l’accesso ai cannabinoidi medici e il monitoraggio mondiale di leggi e politiche in materia di scienza e auto-determinazione.